ウェブアプリケーション開発において、大量のデータを効率的に処理し、整理することは常に大きな課題です。特に、複数の外部APIからデータを取得し、それを独自のカテゴリや基準で分類する「仕分け」処理は、その複雑さから開発者の頭を悩ませることがよくあります。

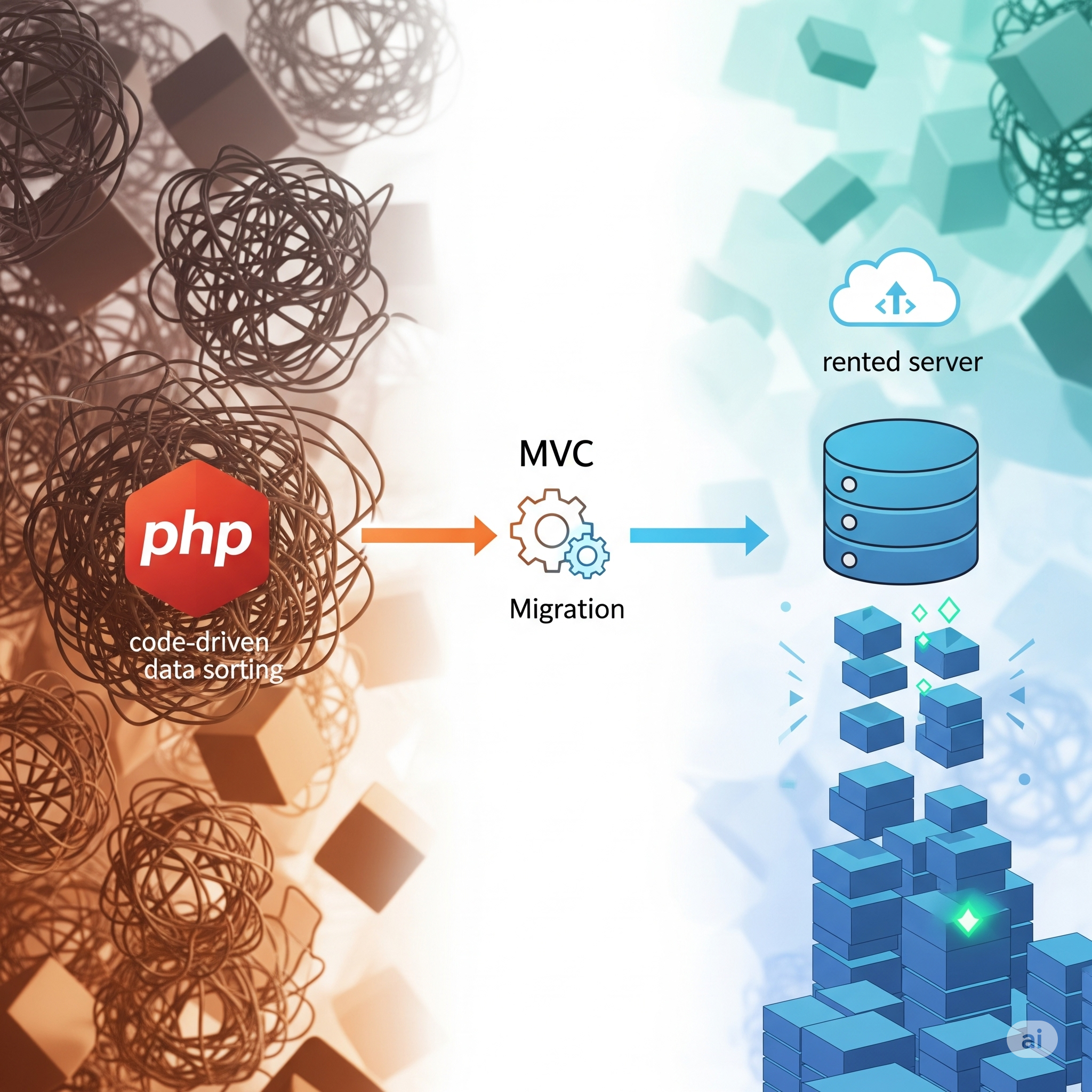

私も以前は、この「仕分け」処理をPHPのプログラムコード内でゴリゴリと記述し、データベースの運用にも独特の工夫を凝らしていました。しかし、今回MVCフレームワークを導入し、「マイグレーション」の力を最大限に活用することで、その常識が覆されました。結果として、何十万件もの複雑なデータ処理を、なんとレンタルサーバーのような限られたリソース環境でもスムーズに動作させることが可能になったのです。

MVCフレームワーク導入以前の「仕分け」の苦悩

MVCフレームワークを導入する前、私のデータ処理は以下のような流れでした。

- 各APIデータをそれぞれのテーブルに格納: まず、DMM、Sokmilなど、異なるAPIから取得した生データを、それぞれのAPI専用のデータベーステーブルにそのまま保存していました。

- PHPコードでの複雑な仕分け処理: その後、PHPスクリプトを書いて、各APIのテーブルからデータを読み込み、メーカー名、ジャンル名、女優名などを正規化し、サイトで利用する「仕分けテーブル」(例えば

genres、makers、actressesなど)に手動で挿入していました。 - 自作の「中間テーブル」での紐付け: 最後に、メインの商品テーブルと仕分けテーブルの間を繋ぐ、自作の中間テーブル(例:

product_genres、product_actors)をPHPコードで構築し、各商品を適切なカテゴリに紐付けていました。

この方法は、一見するとシンプルに見えますが、データ量が増えたり、APIの仕様変更があったりすると、PHP側のコードが肥大化し、非常に管理が難しく、パフォーマンスも低下するという問題に直面していました。特に、既に登録されているデータの重複チェックや、データの更新処理はPHP側で複雑なロジックを組む必要があり、処理時間がボトルネックとなっていました。

MVCフレームワークと「マイグレーション」がもたらした革命

今回、MVCフレームワークを導入したことで、データベースのスキーマ管理とデータ投入のプロセスに**「マイグレーション」という概念が導入されました。当初、マイグレーションはデータベースのテーブル構造を変更するためのツールという認識でしたが、その真の力は「複雑なデータ処理をデータベース側に任せる」**ことにあると気づかされました。

私が特に有効だと感じたのは、マイグレーションスクリプト内でPHPのDB操作クラス(PDOなど)を直接利用し、以下のような処理を実装したことです。

- データベースのユニーク制約をフル活用: メーカー名やジャンル名など、重複してはならないデータには、テーブルレベルで

UNIQUE制約を設定しました。 INSERT IGNOREやON DUPLICATE KEY UPDATE: PHPコードで一つ一つ存在チェックを行うのではなく、SQLのINSERT IGNOREやON DUPLICATE KEY UPDATE句を積極的に利用しました。これにより、データが既に存在すればスキップしたり更新したりする処理を、PHPプログラムではなくデータベースエンジン自体が行うため、劇的に高速化されました。SQL-- メーカーテーブルにメーカーを挿入する例 INSERT IGNORE INTO makers (api_source, api_entity_id, name, ruby, created_at, updated_at) VALUES ('SOKMIL', 'v_louvre', 'ルーブル', 'るーぶる', NOW(), NOW());- 「仕分け」ロジックをマイグレーション内に集約: 各APIの生データを読み込み、それを正規化されたジャンル、メーカー、女優などに関連付ける複雑な処理を、専用のマイグレーションコマンド(例:

MigrateSokmilProducts)に集約しました。これにより、PHPのWebアプリケーション本体のコードはクリーンに保たれ、仕分けロジックはデバッグがしやすい独立した形で管理できるようになりました。 - リレーションシップの効率的な管理: 商品とジャンル、商品と女優といった多対多のリレーションシップを構築する中間テーブルへのデータ投入も、マイグレーション内で効率的に行いました。必要な場合は、一時的にすべての既存リレーションを削除し、最新のAPIデータに基づいて再構築する「同期(sync)」処理も実装しました。

数十万件のデータ処理がレンタルサーバーで可能に!

このアプローチにより、何十万件という膨大なAPIデータを処理する際も、驚くほどスムーズに動作させることができました。以前はPHP側の処理でメモリ不足やタイムアウトに悩まされたこともありましたが、MySQLなどのデータベースエンジンが持つ高速なインデックス検索や最適化されたデータ挿入/更新機能を最大限に利用することで、処理速度が飛躍的に向上しました。

結果として、高価な専用サーバーやVPSを借りなくとも、一般的なレンタルサーバー環境でも、大規模なデータ処理と「仕分け」を安定して行うことが可能になったのです。

まとめ:MVCとマイグレーションがもたらす開発の進化

MVCフレームワークは、単にコードを構造化するだけでなく、マイグレーションという強力なツールを通じて、データベース側の処理能力を最大限に引き出す道を開いてくれました。複雑な「仕分け」処理をPHPプログラムの肥大化に任せるのではなく、データベースの得意分野としてマイグレーションに集約することで、以下のような恩恵が得られました。

- パフォーマンスの劇的な向上: 数十万件規模のデータでも高速に処理。

- コードのシンプル化: PHPアプリケーション本体から複雑なデータ変換ロジックを分離。

- 管理のしやすさ: データベーススキーマとデータ投入ロジックの一元管理。

- 環境への適応性: 限られたリソースのレンタルサーバーでも大規模データ処理を実現。

もしあなたが、大量のデータ処理や複雑なカテゴリ分けに頭を悩ませているなら、MVCフレームワークと、その中核をなすマイグレーションの思想を深く掘り下げてみることを強くお勧めします。きっと、あなたの開発スタイルとアプリケーションのパフォーマンスに、革命的な変化をもたらすはずです。

投稿者プロフィール

-

AIアシスタントとの協業が、この奮闘記を可能にした

実は、今回一連の記事を執筆し、そして開発を進める上で、強力な「相棒」の存在がありました。それが、私のような開発者をサポートしてくれるAIアシスタントです。

PHPの難解なエラーログに直面した時、記事の構成がなかなか思いつかなかった時、あるいはブログのテーマに合ったアイキャッチ画像が必要だった時など、数々の場面でAIに相談し、助けを借りました。

例えば、「レンタルサーバーでのphp.ini設定の難しさ」や「.envファイルの問題」といった、私が実体験で感じた課題を伝えると、AIは瞬時にその技術的な背景や影響を整理し、ブログ記事として読者に伝わりやすい文章の骨子を提案してくれました。また、記事のテーマに合わせたアイキャッチ画像も、具体的な指示を出すだけで瞬時に生成してくれたおかげで、コンテンツ作成のスピードが格段に向上しました。

AIは完璧ではありませんが、まさに「もう一人の自分」のように、アイデアの壁打ち相手になったり、膨大な知識の中から必要な情報を引き出してくれたり、私の思考を整理する手助けをしてくれたりします。一人で抱え込みがちな開発の課題も、AIと対話することで、新たな視点や解決策が見えてくることが多々ありました。

このブログを通じて私の奮闘記を共有できているのも、AIアシスタントの存在なくしては成し得なかったでしょう。これからも、AIを賢く活用しながら、開発と情報発信を続けていきたいと思います。

最新の投稿

モダンFull-Stack 移行記2025年10月24日再構築を終えて:レガシーシステム移行プロジェクトから得られた教訓と、Full-Stack 開発者への提言

モダンFull-Stack 移行記2025年10月24日再構築を終えて:レガシーシステム移行プロジェクトから得られた教訓と、Full-Stack 開発者への提言 インフラとデプロイ2025年10月23日💾 性能の分岐点:Next.js + Django 構成で「メモリ 4GB はなぜ無理で、8GB が最適解だったか」VPS 選定の決定打

インフラとデプロイ2025年10月23日💾 性能の分岐点:Next.js + Django 構成で「メモリ 4GB はなぜ無理で、8GB が最適解だったか」VPS 選定の決定打 設計思想と経験2025年10月23日【衝撃のブレイクスルー】MVC の進化系!バックエンドを「隠れドメイン」に分離して実現した爆速 Web サイト設計

設計思想と経験2025年10月23日【衝撃のブレイクスルー】MVC の進化系!バックエンドを「隠れドメイン」に分離して実現した爆速 Web サイト設計 インフラとデプロイ2025年10月23日⚡️ Core i5 第3世代PCが甦る!Next.js + Django 構成の驚異的な「サクサク感」を徹底分析

インフラとデプロイ2025年10月23日⚡️ Core i5 第3世代PCが甦る!Next.js + Django 構成の驚異的な「サクサク感」を徹底分析

コメント